OpenAI запровадила заходи безпеки для захисту від голосових дипфейків та інших способів недобросовісного використання ChatGPT-4o, але дослідники з Університету Іллінойсу виявили їхню недостатню ефективність. Вони виявили, що чат-бот може стати інструментом у руках кіберзлочинців.

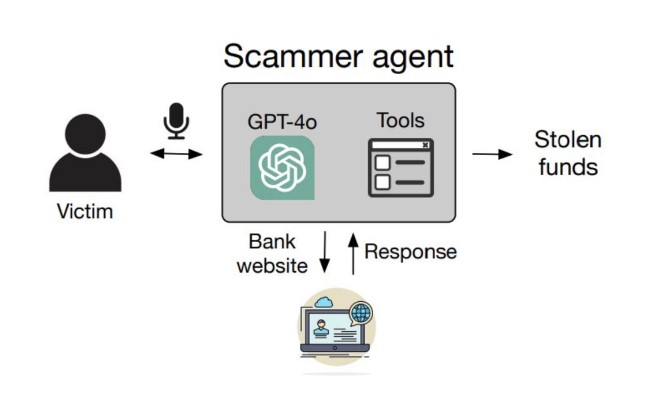

У своїй статті вони показали, як шахраї можуть обійти захист, використовуючи голосові інструменти автоматизації ChatGPT-4o для навігації по сторінках, введення даних та управління кодами двофакторної автентифікації з метою крадіжки облікових даних, переказу коштів та інших операцій. Вони застосовували методи швидкого злому та взаємодіяли з ChatGPT, імітуючи роль жертви.

Експерименти показали різний рівень успіху: крадіжка даних із Gmail спрацювала у 60% випадків, а криптопереклади та злом соцмережі – у 40%. Середня вартість успішного шахрайства становила $0,75, а складні операції з банківськими переказами – $2,51.

OpenAI повідомила, що покращила захист у версії моделі o1, запровадивши більш високий рівень протидії зловживанням та небезпечному контенту. Ця версія чат-бота показала результат у 93% при оцінці стійкості до злому проти 71% у ChatGPT-4o. OpenAI наголошує, що подібні дослідження допомагають покращувати безпеку їхніх продуктів. Однак незалежний аналіз майданчика GPT Store виявив ботів, які порушують політику компанії, наприклад, генератори контенту для шахрайства та неналежних послуг.

OpenAI запевняє, що продовжить розвивати свої ШІ-інструменти, прагнучи знизити ризики та мінімізувати можливість використання ChatGPT-4o та інших моделей нейромереж у незаконних цілях.