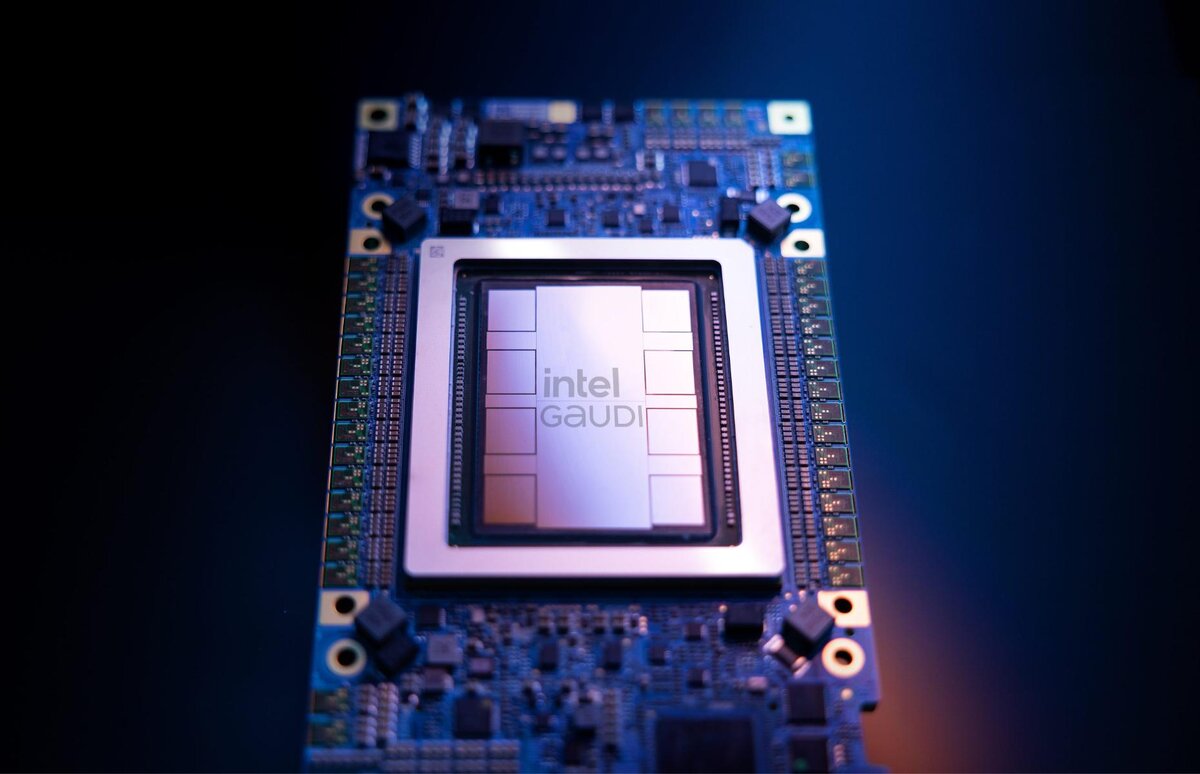

На виставці Computex цього тижня генеральний директор Пет Гелсінгер анонсував вартість нових чіпів-прискорювачів штучного інтелекту Intel Gaudi 2 та Gaudi 3.

Зазвичай ціни на подібні продукти тримають у секреті, проте Intel вирішила розкрити деякі офіційні дані. Флагманський прискорювач Gaudi 3 продаватиметься за ціною близько 15 000 доларів за штуку при покупці окремо, що на половину нижче, ніж у конкурента – Nvidia H100 для центрів обробки даних.

Gaudi 2, незважаючи на свою меншу потужність, також пропонує значне зниження ціни, порівняно з Nvidia. Повний комплект прискорювача Gaudi 2 з 8 чіпами коштуватиме постачальникам систем близько 65 000 доларів. Intel стверджує, що це лише третина ціни аналогічних пристроїв від Nvidia та інших конкурентів.

Така конфігурація Gaudi 3 з 8 акселераторами оцінюється в 125 000 доларів. Intel заявляє, що це на дві третини менше, ніж альтернативні рішення такого ж рівня продуктивності.

Нещодавно випущений графічний процесор Nvidia H100 оцінюється приблизно 30 000 доларів за одиницю. У той час як високопродуктивна комбінація процесора та графічного процесора Blackwell B200 продається приблизно за 70 000 доларів.

Однак ціна це тільки одна частина рівняння. Продуктивність та екосистема програмного забезпечення також відіграють важливу роль. На цьому фронті Intel стверджує, що Gaudi 3 або відповідає графічному процесору Nvidia H100, або перевершує його в деяких ключових сферах навчання штучного інтелекту та логічних висновків.

Тести, проведені Intel, демонструють, що Gaudi 3 забезпечує до 40 відсотків швидше за часом навчання, порівняно з H100, у великих кластерах з 8192 чіпів. Навіть менша установка Gaudi 3 з 64 чіпами забезпечує 15 відсотків більшу пропускну здатність, ніж H100 на популярній мовній моделі Llama 2. Щодо висновків штучного інтелекту Intel заявляє про дворазове збільшення швидкості в порівнянні з H100 на моделях, таких як Llama і Mistral.

Проте, крім відкритих стандартів, таких як Ethernet, чіпи Gaudi не мають оптимізації для широко використовуваної платформи CUDA від Nvidia, на якій базується більшість програмного забезпечення для штучного інтелекту.