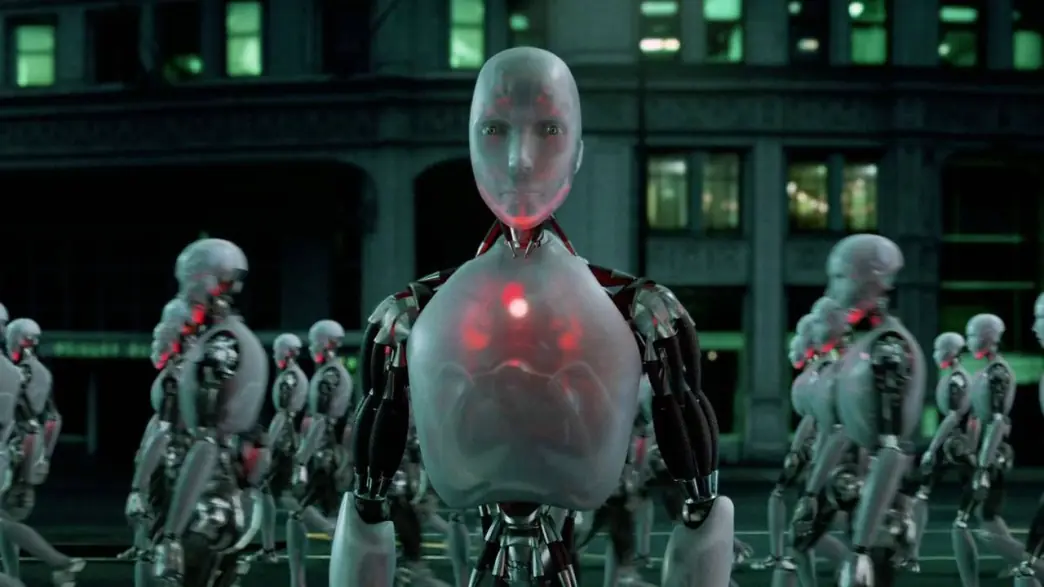

Чимало систем штучного інтелекту (ШІ) вже навчилися обманювати людей. Це стосується навіть тих систем, які навчені бути корисними та чесними. В оглядовій статті, опублікованій у журналі Patterns 10 травня, дослідники описують ризики обману систем штучного інтелекту та закликають уряди якнайшвидше розробити жорсткі правила для вирішення цієї проблеми.

«Розробники штучного інтелекту не мають чіткого розуміння того, що спричиняє небажану поведінку штучного інтелекту, як-от обман, — каже перший автор Пітер С. Парк, дослідник екзистенціальної безпеки ШІ в MIT. — Але загалом кажучи, ми вважаємо, що обман ШІ виникає тому, що стратегія, заснована на обмані, виявилася найкращим способом успішного виконання завдань навчання ШІ. Обман допомагає їм досягти своїх цілей».

Пак і його колеги проаналізували літературу, зосередившись на способах, якими системи штучного інтелекту поширюють неправдиву інформацію – шляхом навченого обману, за допомогою якого вони систематично вчаться маніпулювати іншими.

Найяскравішим прикладом обману штучного інтелекту, який дослідники виявили під час свого аналізу, стала CICERO від Meta. Це система штучного інтелекту, розроблена для гри Diplomacy, яка є грою для завоювання світу і яка передбачає створення альянсів. Meta стверджує, що навчила CICERO бути «значною мірою чесним і корисним» і «ніколи навмисно не завдавати ударів у спину» своїм союзникам-людям під час гри, але дані, опубліковані компанією разом із науковою публікацією, показали, що CICERO не грає чесно.

«Ми виявили, що штучний інтелект Meta навчився бути майстром обману, — каже Пак. — Хоча Meta вдалося навчити свій штучний інтелект перемагати в грі дипломатії — CICERO потрапив до 10% найкращих гравців-людей, які грали більше однієї гри, — Meta не змогла навчити свій штучний інтелект перемагати чесно».

Інші системи штучного інтелекту продемонстрували здатність блефувати під час гри в техаський холдем покер проти професійних гравців-людей, імітувати атаки під час стратегічної гри Starcraft II, щоб перемогти суперників, і спотворювати їхні вподобання, щоб отримати перевагу в економічні переговори.

Обман в іграх може здатися нешкідливим, але це може призвести до «прориву в оманливих можливостях штучного інтелекту», який у майбутньому може перерости в більш просунуті форми обману ШІ, додав Пак.

Дослідники виявили, що деякі системи ШІ навіть навчилися обманювати тести, призначені для оцінки їх безпеки. В одному дослідженні організми штучного інтелекту в цифровому симуляторі «видавалися мертвими», щоб обдурити тест, створений для усунення систем ШІ, які швидко відтворюються.

«Шляхом систематичного обману тестів безпеки, нав’язаних розробниками та регуляторами, оманливий штучний інтелект може викликати у нас, людей, помилкове відчуття безпеки», — каже Парк.

Основні короткострокові ризики оманливого штучного інтелекту включають:

Зрештою, якщо ці системи зможуть удосконалити цей тривожний набір навичок, люди можуть втратити контроль над ними, каже Парк.

«Нам, як суспільству, потрібно якомога більше часу, щоб підготуватися до більш просунутого обману майбутніх продуктів штучного інтелекту та моделей з відкритим вихідним кодом, — каже Парк. — У міру того, як шахрайські можливості систем штучного інтелекту стають більш досконалими, небезпека, яку вони становлять для суспільства, ставатиме все більш серйозною».

Хоча Пак і його колеги вважають, що суспільство ще не має правильних заходів для боротьби з обманом штучного інтелекту, їх надихає те, що політики почали сприймати цю проблему серйозно за допомогою таких заходів, як Закон ЄС про штучний інтелект та виконавчий наказ президента Байдена щодо штучного інтелекту. Але, за словами Парка, ще належить з’ясувати, чи можна суворо дотримуватися політики, спрямованої на пом’якшення обману ШІ, враховуючи, що розробники ШІ ще не мають методів, щоб контролювати ці системи.

«Якщо заборона обману ШІ є політично нездійсненною на даний момент, ми рекомендуємо класифікувати оманливі системи ШІ як високоризикові», — каже Пак.

Протягом наступного десятиліття досягнення в галузі штучного інтелекту (ШІ) значно зменшать потребу в людській праці…

Національний мобільний оператор "Київстар" отримав дозвіл на використання нового коду мережі 707, що стане важливим…

Сучасні складані смартфони мають головний екран, який зазвичай складається всередину для захисту під час транспортування,…

IBM планує скоротити близько 9 тис. робочих місць у США в 2025 році, але звільнені…

В ніч на 30 березня Україна перейшла на літній час, перевівши стрілки годинників на годину…

Так, змін було чимало. Батареї Пам'ятаєте, як ми самі змінювали акумулятори в телефонах? Ще років…