Інструменти штучного інтелекту, такі як Microsoft Copilot, OpenAI ChatGPT або Google Gemini, та моделі, що їх підтримують, розміщуються у хмарах з величезними потужностями. Ці моделі мають мільярди або навіть трильйони параметрів і, звичайно, не можуть працювати на смартфонах або комп’ютерах. Однак компанія Microsoft представила малогабаритну модель Phi-3 Mini, яка може запропонувати продуктивність, аналогічну найбільшим мовним моделям на ринку.

Phi-3 Mini, одна з трьох компактних мовних моделей ШІ, над якими працює Microsoft, має вагу 3,8 млрд. параметрів. Найближчим часом Microsoft планує доповнити цю родину моделями Phi-3 Small (7 млрд параметрів) та Phi-3 Medium (14 млрд). Microsoft стверджує, що Phi-3 Mini, незважаючи на свої невеликі розміри, за потужністю не поступається іншим величезним моделям, які в 10 разів більші за неї.

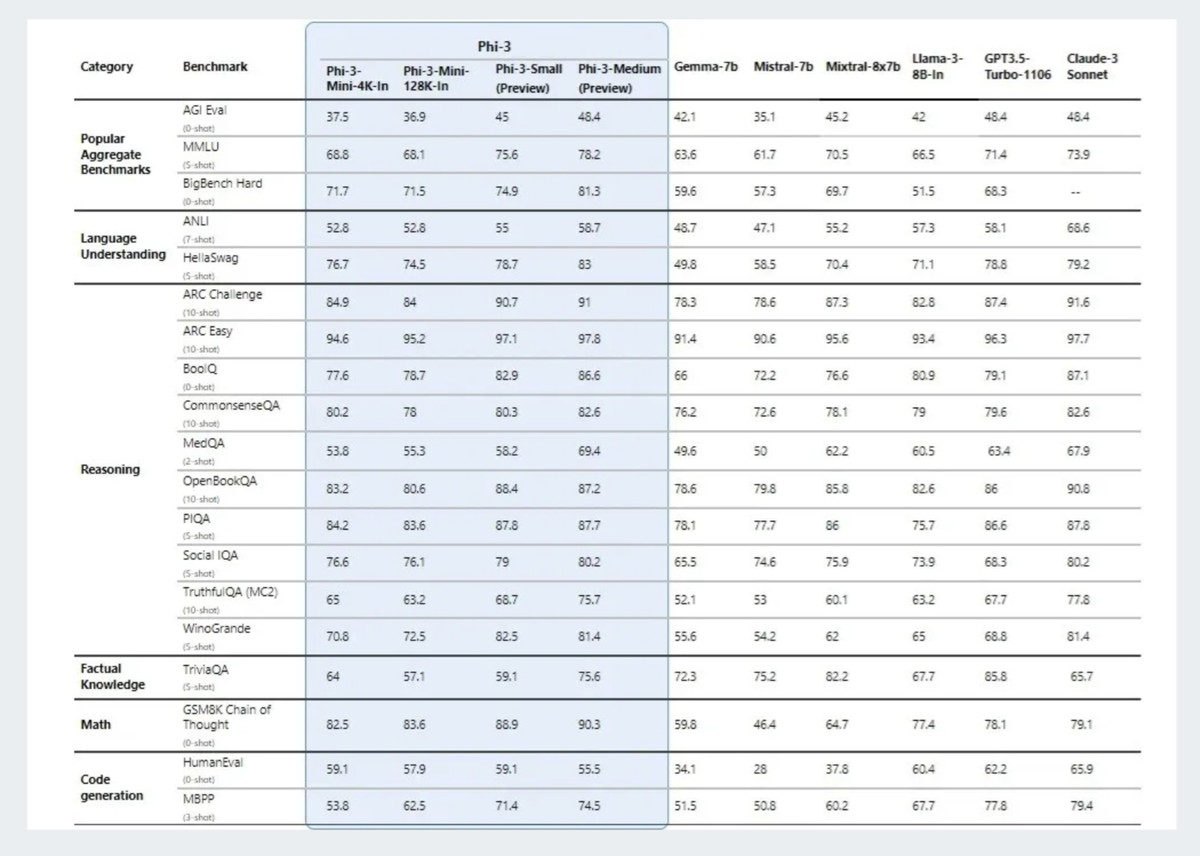

Згідно з даними, наданими Microsoft, які ви можете бачити на зображенні нижче, Phi-3 Mini може конкурувати з GPT-3.5 зі 175+ млрд параметрів, на якому працює ChatGPT, моделлю Mixtral 8x7B від Mistral та моделлю Claude 3 Sonnet від Anthropic. Не забувайте, що Phi-3 Mini – це модель ШІ, яка працює на пристрої, як смартфони, і не потребує підключення до хмари.

Як правило, для “інтелектуальніших” моделей ШІ потрібно більше параметрів. Параметри в ШІ – це змінні, які модель дізнається у процесі навчання. Це внутрішні змінні, які модель використовує для прогнозування чи ухвалення рішень. Більшість параметрів зазвичай означає більш глибоке розуміння ваших запитів. Однак паралельно зростають і вимоги до обчислень.

З іншого боку, дослідники Microsoft стверджують, що досягли дивовижних результатів у Phi-3 Mini за рахунок поліпшення самих навчальних даних. Сучасні масивні моделі ШІ навчаються на “усім”, що є в Інтернеті та в бібліотеках. У цьому наборі даних можуть бути як непотрібні, так і корисні речі. Microsoft навчала Phi-3 Mini на ретельно підібраному наборі даних, що складається з високоякісного веб-контенту та синтетично згенерованого матеріалу, розробленого на основі попередніх моделей Phi. Це забезпечило високу продуктивність моделі її розміру. Одним словом, наголос було зроблено на якість, а не на кількість.

При цьому модель може одночасно обробляти до 4 000 токенів контексту, а також доступна спеціальна версія із 128 токенами. Microsoft зробила цю модель доступною з відкритим вихідним кодом на Azure, Hugging Face та Ollama. Найближчим часом компанія планує запустити Phi-3 Small (7B параметрів) та Phi-3 Medium (14B параметрів).